비전-언어 모델 바탕의 미세 조정으로 특정 객체 식별 능력 크게 향상

MIT 연구팀이 ‘비전-언어 모델(VLM)’에게 특정한 장면 속에서 개인화된 객체의 위치를 파악하도록 가르치는 새로운 인공지능 훈련 방법을 개발했다고 MIT 뉴스가 16일(현지시간) 보도했다.

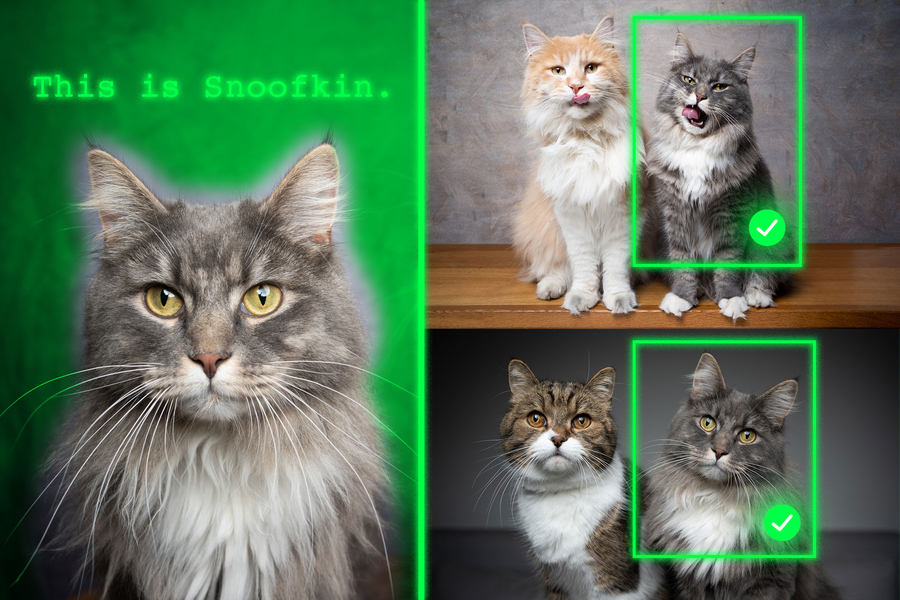

예를 들어 한 사람이 자신의 프렌치 불독‘바우저’를 반려견 공원에 데려갔을 경우, 견주는 다른 개들 사이에서 노는 바우저를 현장에서 쉽게 알아볼 수 있다. 하지만 이 사람이 직장에서 GPT-5와 같은 생성형 블랙잭사이트 모델을 사용해 자신의 반려동물을 모니터링한다면, 모델은 이 기본적인 작업에 실패할 수 있다. GPT-5와 같은 비전-언어 모델(VLM)은 ‘개’와 같은 일반적인 객체를 인식하는 데는 뛰어나지만, ‘프렌치 불도그 바우저’와 같은 개인화된 객체를 찾는 데는 취약한 성능을 보인다는 것이다.

MIT와 MIT-IBM 왓슨 블랙잭사이트 랩, 와이즈만 과학연구소 등으로 이뤄진 공동 연구팀이 개발한 새로운 블랙잭사이트 훈련 방법은 동일한 객체를 여러 프레임에 걸쳐 추적하는 ‘비디오 트래킹 데이터’를 사용한다. 연구팀은 모델이 이전에 암기한 지식에 의존하는 대신, '맥락적 단서(contextual clues)'에 집중해야만 개인화된 객체를 식별할 수 있도록 데이터셋을 설계했다.

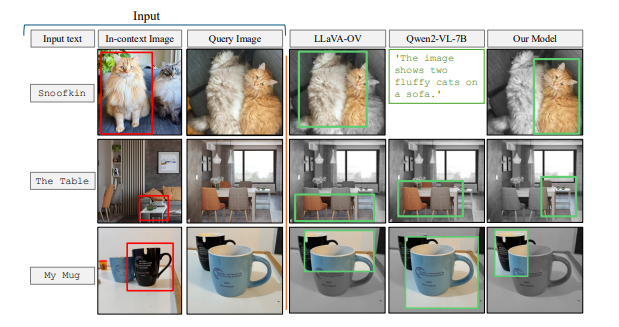

자신의 애완동물처럼 개인화된 객체를 보여주는 몇 가지 예시 이미지를 제공받으면, 이 방법으로 재훈련된 모델은 새로운 이미지에서도 동일한 애완동물의 위치를 더 잘 식별할 수 있다. 이 모델은 이 작업에서 기존의 최첨단 시스템보다 뛰어난 성능을 보였다. 중요한 점은 이 기술이 모델의 나머지 일반적인 능력은 그대로 유지시킨다는 것이라고 연구팀은 설명했다.

이 새로운 접근 방식은 미래의 블랙잭사이트 시스템이 시간 경과에 따라 특정 물체를 추적하거나, 생태 모니터링에서 특정 동물 종과 같은 관심 객체를 찾아내는 데 도움을 줄 수 있다. 또한 시각 장애인이 방 안의 특정 물건을 찾는 데 도움을 주는 블랙잭사이트 기반 보조 기술 개발에도 기여할 수 있다.

논문 주요 저자인 제핸젭 미르자 MIT 박사후 연구원은 “궁극적으로 우리는 이 모델들이 인간처럼 맥락을 통해 학습할 수 있기를 원한다”며 “모델이 이를 잘 해낼 수 있다면, 매번 새로운 작업을 위해 재훈련하는 대신 몇 가지 예시만 제공해도 맥락을 이해하고 작업 수행 방법을 추론할 수 있을 것이다. 이는 매우 강력한 능력”이라고 말했다.

이번 연구는 국제 컴퓨터 비전학회(ICCV)에서 발표될 예정이다. (논문 제목:Teaching VLMs to Localize Specific Objects from In-context Examples)

연구자들은 대규모언어모델(LLM)이 맥락 학습에 뛰어날 수 있음을 발견했다. LLM에게 덧셈 문제와 같은 작업의 몇 가지 예시를 제공하면, 제공된 맥락을 기반으로 새로운 덧셈 문제에 답하는 법을 배울 수 있다.

비전-언어 모델(VLM)은 본질적으로 LLM에 시각적 구성요소가 연결된 것이므로, MIT 연구팀은 VLM이 LLM의 맥락 내 학습 능력을 물려받을 것이라 생각했다. 하지만 실제로는 그렇지 않았다. 연구팀은 “연구계는 아직 이 특정 문제에 대한 명확한 답을 찾지 못했다. 두 구성요소를 병합하는 과정에서 일부 시각 정보가 손실되어 병목 현상이 발생할 수 있지만, 우리는 정확한 이유를 모른다”고 말했다.

연구팀은 새로운 이미지에서 특정 객체를 찾는 ‘맥락 내 위치 파악(in-context localization)’ 능력을 개선하기 위해 VLM을 미세 조정(fine-tuning)하는 데 사용되는 데이터에 집중했다. 연구팀은 기존 비디오 트래킹 데이터에서 샘플을 선별해 새로운 데이터셋을 개발했다. 이 데이터는 ‘초원을 달려가는 호랑이’처럼 동일한 객체가 장면을 통해 움직이는 비디오 클립이다.

연구팀은 이 비디오에서 프레임을 잘라내어, 각 입력이 동일한 객체를 다른 맥락에서 보여주는 여러 이미지와 그 위치에 대한 질문 및 답변 예시로 구성되도록 데이터셋을 구조화했다. 연구팀은 “다른 맥락에 있는 동일한 객체의 여러 이미지를 사용함으로써, 모델이 맥락에 집중하여 관심 객체의 위치를 일관되게 파악하도록 유도했다”고 설명했다.

하지만 연구팀은 VLM이 ‘속임수’를 쓰는 경향이 있음을 발견했다. 맥락 단서를 기반으로 답하는 대신, 사전 훈련 중에 얻은 지식을 사용해 객체를 식별하려 했다. 예를 들어, 모델이 이미 호랑이 이미지와 ‘호랑이’라는 레이블이 상관관계가 있음을 학습했기 때문에, 맥락에서 추론하는 대신 이 사전 훈련된 지식을 기반으로 초원을 달리는 호랑이를 식별할 수 있었다.

이 문제를 해결하기 위해 연구팀은 데이터셋에 실제 객체 범주 이름 대신 ‘가짜 이름(pseudo-names)’을 사용했다. 이 경우, 호랑이의 이름을 ‘찰리’로 변경했다. 모델은 ‘찰리’가 호랑이일 수 있다는 것을 모르기 때문에, 맥락을 보도록 강제된다.

연구팀은 또한 데이터 다양성을 확보하기 위해 프레임이 너무 가깝지 않도록 조정하는 등 최적의 데이터 준비 방법을 찾는 데에도 어려움을 겪었다. 결과적으로, 이 새로운 데이터셋으로 VLM을 미세 조정한 결과, 개인화된 객체 위치 파악 정확도가 평균 약 12% 향상됐다. 가짜 이름을 포함한 데이터셋을 사용했을 때는 성능 향상 폭이 21%에 달했다. 모델 크기가 커질수록 성능 향상 폭도 더 커졌다.

향후 연구팀은 VLM이 LLM으로부터 맥락 내 학습 능력을 상속받지 못하는 잠재적인 이유를 연구할 계획이다. 또한, 새로운 데이터로 재훈련할 필요 없이 VLM의 성능을 향상시킬 수 있는 추가 메커니즘을 탐색할 예정이다.

밀라-퀘벡 블랙잭사이트 연구소의 사우라브 자 박사후연구원은 “이번 연구는 ‘퓨샷 개인화 객체 위치 파악(few-shot personalized object localization)’ 문제를 ‘명령어 튜닝(instruction-tuning)’ 문제로 재구성하고, 비디오 트래킹 시퀀스를 사용해 VLM이 클래스 사전 지식(class priors)이 아닌 시각적 맥락을 기반으로 위치를 파악하도록 가르친다”고 평가했다. 이어 “로보틱스, 증강현실(AR) 비서, 창의적 도구 등 실제 워크플로우 사용자에게 있어 미세 조정 없이 신속하게 특정 객체를 지목하는 능력은 매우 중요하다. 이 연구가 제공하는 실용적이고 데이터 중심적인 레시피는 비전-언어 파운데이션 모델의 광범위한 채택을 향상하는 데 도움이 될 수 있다”고 말했다.

백승일 기자 robot3@irobotnews.com